DeepSeek本地部署 自建数据库

DeepSeek本地部署、自建数据库

本文将详细介绍如何在本地电脑上部署Deepseek大模型,并搭建基于知识库的私人问答系统。整个过程分为模型部署和知识库搭建两部分,适合个人开发者或企业用户使用。

一、部署Deepseek模型

1. 安装Ollama

Ollama是一个管理和运行开源大模型的平台,支持Deepseek系列模型。

步骤:

- 访问Ollama的GitHub仓库,下载最新版本的安装包(如

ollama-setup.exe)。 - 运行安装包,按提示完成安装。

- 安装完成后,在命令行输入

ollama,若显示帮助指令则说明安装成功。

2. 下载Deepseek模型

Ollama支持多种模型,包括Deepseek的V3和R1版本。

步骤:

- 在命令行中运行以下命令下载模型:

1

ollama run deepseek-r1:8b

- 下载完成后,运行模型:

1

ollama run deepseek-r1:8b

- 输入测试问题(如“你好”),若能正常对话则说明模型部署成功。

3. 配置环境变量(可选)

如果需要修改模型默认存储路径或端口,可以配置环境变量:

OLLAMA_HOST:设置访问端口(默认11434)。OLLAMA_MODELS:指定模型存储路径(避免占用C盘空间)。

二、搭建知识库系统

1. 安装Docker

知识库系统基于Docker运行,需先安装Docker环境。

步骤:

- 访问Docker官网,下载适合系统的安装包。

- 运行安装程序,按提示完成安装。

- 安装完成后,在命令行输入

docker --version,确认安装成功。

2. 配置Docker镜像源(国内用户)

为提高下载速度,建议配置国内镜像源。

步骤:

- 打开Docker设置界面,进入“Docker Engine”配置。

- 添加以下镜像源:

1

2

3{

"registry-mirrors": ["https://registry.docker-cn.com"]

} - 保存并重启Docker。

3. 部署知识库软件RegFlow

RegFlow是一个开源的文档理解与问答框架。

步骤:

- 克隆RegFlow仓库:

1

git clone https://github.com/infiniflow/ragflow.git

- 进入项目目录,修改配置:

- 打开

docker/.env文件,将VERSION改为完整版(如`v0.1.9)。

- 打开

- 启动服务:

1

docker compose -f docker-compose.yml up -d

- 等待服务启动后,访问

http://localhost:80,注册管理员账号。

三、连接模型与知识库

1. 配置Deepseek模型

将本地部署的Deepseek模型接入RegFlow。

步骤:

- 登录RAGFlow,进入“模型设置”。

- 选择“Ollama”作为供应商,添加模型:

- 模型名称:deepseek-r1:8b(需与Ollama中名称一致)。

- 基础URL:

http://<本地IP>:11434(通过ipconfig获取本地IP)。 - Token限制:设为较大值(如

32892)。

- 保存配置。

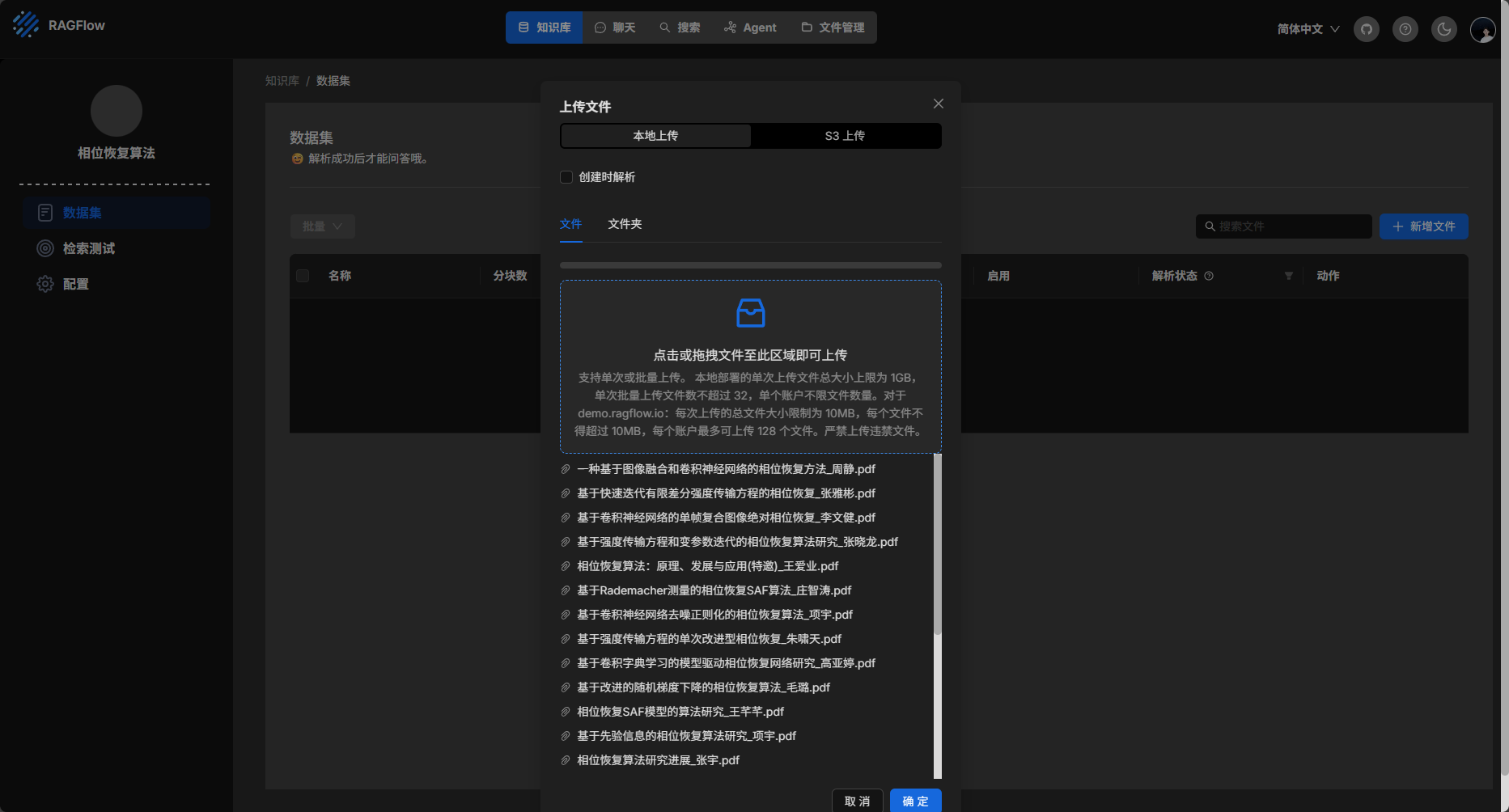

2. 创建知识库

上传文档并构建专属知识库。

步骤:

- 进入“知识库”页面,点击“创建”。

- 语言选择“中文”,嵌入模型选择默认选项。

- 上传文档(支持PDF、DOCX等格式)。

- 点击“开始解析”,等待文档解析完成。

3. 创建问答助理

基于知识库构建问答机器人。

步骤:

- 进入“聊天”页面,点击“新建助理”。

- 名称:自定义(如“法律顾问”)。

- 关联知识库:选择已创建的知识库。

- 保存后即可开始提问,系统会从知识库中检索答案并标注引用来源。

四、常见问题

- 模型下载慢:尝试使用代理或更换网络环境。

- Docker启动失败:检查镜像源配置或端口冲突。

- 知识库解析错误:确保文档格式正确,或更换嵌入模型。

五、总结

通过本文的步骤,你可以轻松在本地部署Deepseek大模型,并搭建一个私有的知识库问答系统。这种方式既保障了数据隐私,又避免了网络不稳定的风险,适合对安全性要求较高的场景。

下载Ollama、Docker和RAGFlow,完成DeepSeek本地部署和自建数据库。

我用夸克网盘分享了「OllamaSetup_3.exe」,点击链接即可保存。链接:https://pan.quark.cn/s/c0294f24340b

我用夸克网盘分享了「Docker Desktop Installer_2.exe」,点击链接即可保存。链接:https://pan.quark.cn/s/fcddb32ba57e

我用夸克网盘分享了「ragflow-0.19.zip」,点击链接即可保存。链接:https://pan.quark.cn/s/d99fdc9d5a71

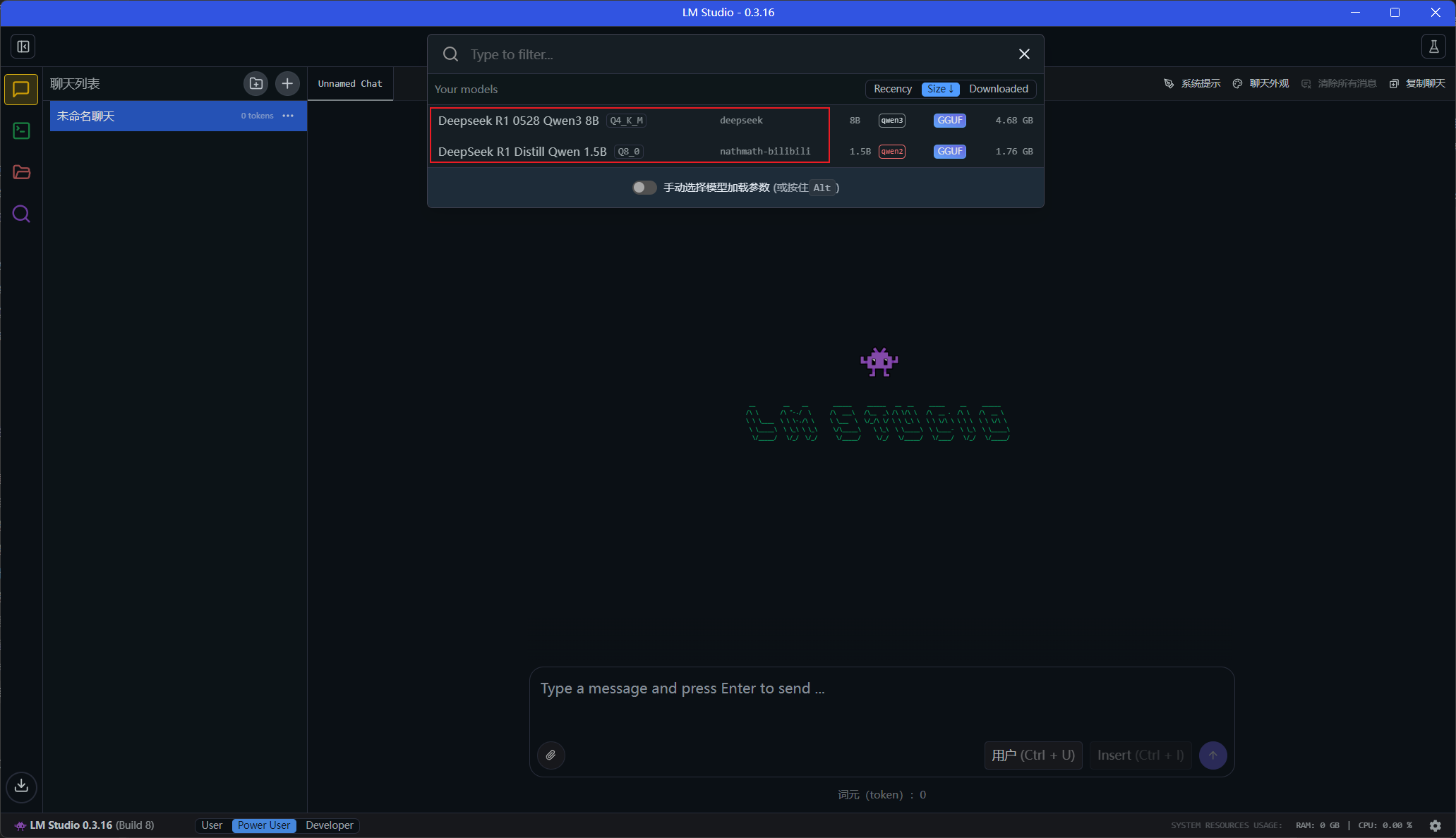

DeepSeek本地简易部署

无需复杂环境配置,快速搭建本地AI知识库

本文将手把手教你如何在Windows系统部署DeepSeek模型并建立本地数据库,让你拥有完全自主掌控的AI助手!

🛠 准备工作

- 获取部署包(含DeepSeek模型)

- 确保系统盘有10GB+可用空间

- 防火墙配置(可选)

🚀 四步部署流程

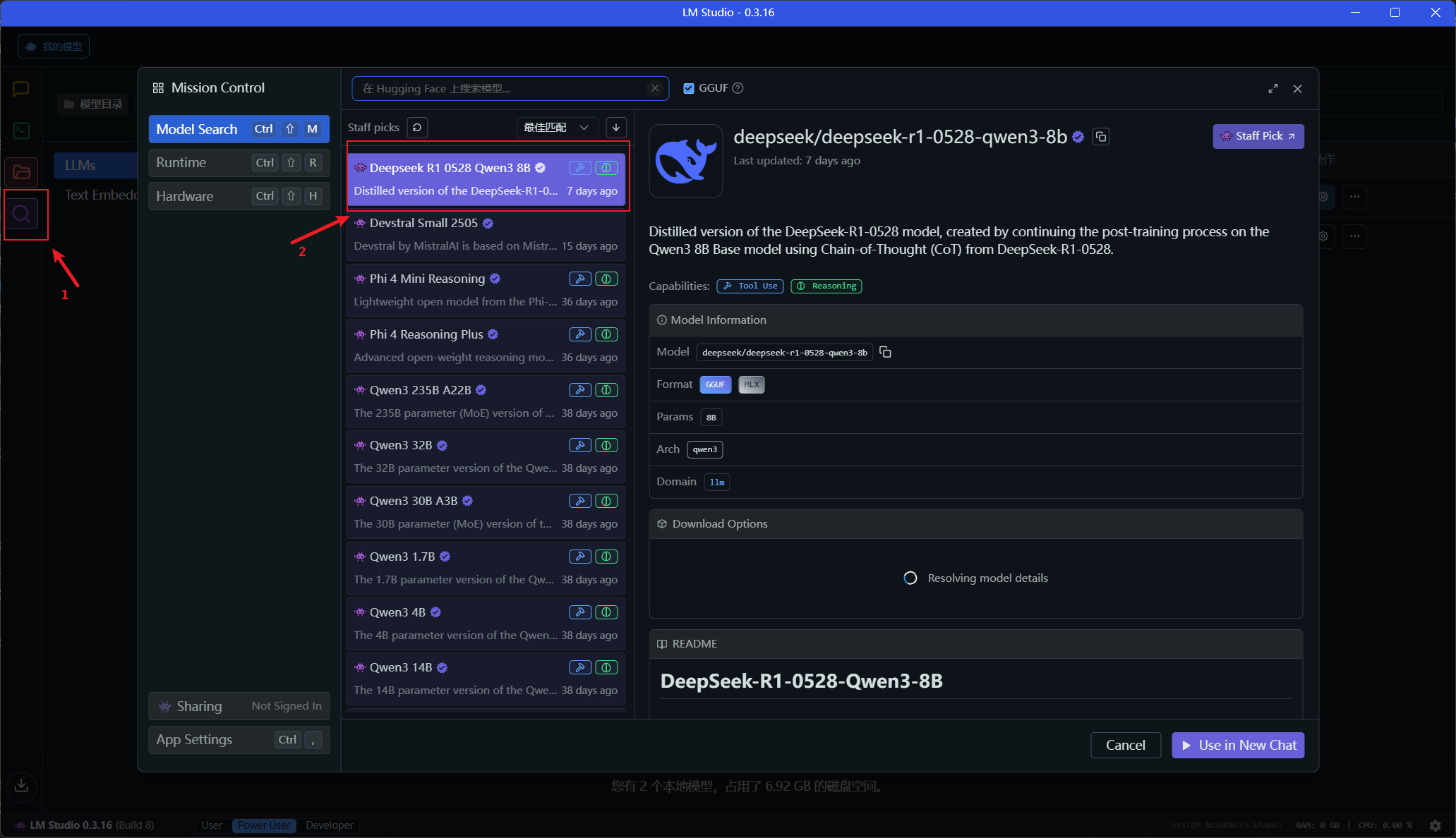

步骤1:配置核心目录

1 | 将下载的".lmstudio"文件夹放置到系统用户目录: |

步骤2:安装主程序

1 | 将"LM Studio"文件夹移动到任意位置(建议非系统盘): |

步骤3:启动运行

1 | 进入"LM Studio"文件夹 → 双击运行"LM Studio.exe" |

首次启动将自动检测环境依赖,耐心等待初始化完成(约1-3分钟)

步骤4:模型与防火墙配置

1 | 1. 基础模型已包含在一键包中,直接可用 |

步骤5:导入模型